BiodivAR : une web app de création pour la réalité augmentée (RA)…

… géolocalisée ! C’est-à-dire, la RA qui se sert du positionnement par satellite (GNSS, ou GPS).

La réalité augmentée est une technologie relativement peu répandue, qui s’est notamment fait connaître à travers le jeu mobile Pokémon Go. Ce jeu a cela de particulier qu’il se joue en extérieur, avec des Pokémons et des arènes réparties autour du monde entier. Les joueurs et les joueuses, galvanisés par ces créatures virtuelles, se mettent ainsi naturellement en mouvement, ce que peu d’autres outils numériques ont su provoquer par le passé. Son succès a été tel qu’il a inspiré plusieurs projets de recherches en technologies de l’éducation : c’est notamment le cas de BiodivAR. Que se passerait-il si, au lieu de chasser des Pokémons, les utilisateur·ice·s parcouraient des milieux naturels en visualisant des informations sur celui-ci « à la volée », à mesure qu’ils ne les découvrent ? Ou qu’ils et elles référencent leurs observations pour collecter des données utiles sur la biodiversité, dans une démarche de science citoyenne ? Voici les enjeux de ce projet, mené en collaboration avec Catherine Audrin et Laura Leon Perez, chercheuses en sciences de l’éducation à la HEP Vaud et l’université de Genève, respectivement.

Au cours de nos recherches, conduites entre 2020 et 2024, nous avons réuni les informations utiles à la conception d’un outil dans une démarche centrée sur l’humain. Cela s’est traduit par des séances d’observations lors d’activités pédagogiques en plein air, des entretiens, des études pilotes, des mesures d’eye tracking, etc. Grâce à cette connaissance du contexte ciblé, nous avons pu définir les besoins auxquels l’outil allait devoir répondre.

L’application BiodivAR permet d’afficher en réalité augmentée des contenus virtuels personnalisés à des emplacements réels (coordonnées géographiques), d’après la position du périphérique.

La qualité de l’ancrage des objets virtuels en RA souffre de l’imprécision relative des données de géolocalisation sur les périphériques mobiles, et l’utilisabilité de ce type d’interface s’en trouve grandement péjorée. C’est pourquoi nous avons cherché à améliorer la situation, en ayant recours à des systèmes de positionnement différentiel (RTK ou «Real-time kinematic»). Nous avons également développé une bibliothèque logicielle qui permet de géoréférencer des objets en RA au sein du framework libre «A-frame». Ainsi, les objets virtuels de notre système sont géoréférencés à des moments clefs (au lieu de l’être en continu, avec les problèmes qui en découlent), et leur ancrage (le suivi positionnel, soit la mesure du déplacement du périphérique dans l’espace) est assuré par des algorithmes de vision par ordinateur, bien plus précis. Nous avons intégré ces outils à la plateforme que nous avons conçue, accessible à l’URL <biodivar.heig-vd.ch>. Celle-ci permet de concevoir des parcours augmentés en créant des points d’intérêt sur une carte en ligne, et en peuplant ces points avec des médias (images, textes, sons…). Le développement de cette plateforme a été décrit dans un article revu par les pairs [1].

Crédit photo: Eddy Mottaz / Le Temps

Dans une étude pilote [2], nous avons cherché à vérifier si l’amélioration de la précision des données de géolocalisation se convertissait en une meilleure utilisabilité (c’est-à-dire : si l’outil est perçu comme efficace, efficient et satisfaisant). Pour les besoins de cette étude, nous avons conçu un parcours didactique sur la biodiversité au moyen de la plateforme BiodivAR. L’étude a indiqué que la précision augmentait effectivement l’utilisabilité, mais aussi que la stabilité (ou continuité) dans les données primait sur la précision absolue.

Par la suite, nous nous sommes intéressés à l’attention visuelle lors de l’utilisation de l’outil. Lors d’un second test pilote, nous avons mesuré la direction du regard (en anglais : gaze) des participant·e·s. Nous avons analysé ces données en entraînant un modèle de vision par ordinateur pour classifier chaque frame, et déterminer la position du regard par rapport à la tablette [3]. Nous avons ainsi observé que l’attention visuelle était influencée par les instructions verbales données au début de l’activité : certains participant ont interagi significativement plus avec l’écran de la tablette lorsqu’on ne leur conseillait pas de regarder les arbres lors de l’activité. Ces résultats ont été publiés dans un article revu par les pairs [4].

En enregistrant le point de vue des utilisateurs et la direction de leur regard au moyen de lunettes d’eye tracking, il est possible de faire une mesure objective du temps passé à visualiser l’écran de la tablette.

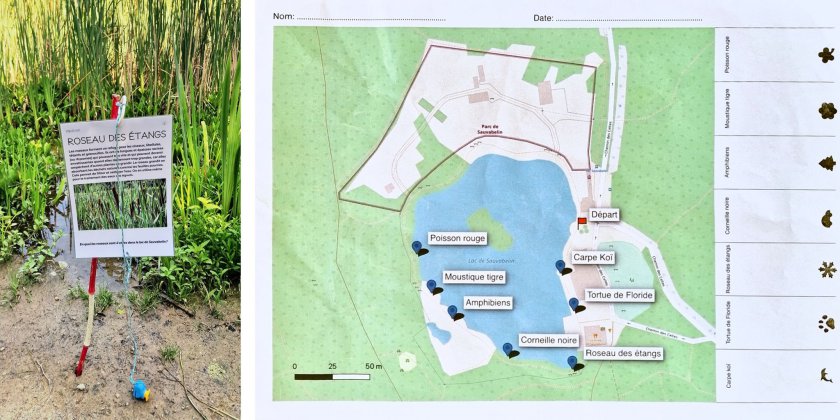

Finalement, nous avons mis sur pied une étude interventionnelle en milieu scolaire, avec 10 classes de l’établissement secondaire Isabelle-de-Montolieu à Lausanne, dans le cadre du cours de science de la nature. Nous avons conçu un nouvel environnement augmenté autour du lac de Sauvabelin au moyen de l’outil BiodivAR, en collaborant avec les personnes en charge du suivi biologique du lac. Le parcours pédagogique proposait deux zones avec des thématiques différenciées : l’une sur les espèces de rente menacées de disparition (car supplantée par des espèces plus rentables), l’autre sur les espèces invasives et l’équilibre du biotope du lac. Chaque élève était muni d’un pédomètre et a exploré l’une des zones avec une tablette et l’application BiodivAR, et l’autre avec une carte et des postes en papier. À l’issue des explorations, les élèves ont complété des questionnaires de connaissances ainsi que sur les émotions environnementales. L’analyse de ces données a montré que les élèves avaient mieux assimilé les contenus visualisés en réalité augmentée. Ils ont également exploré la nature de façon plus active, en parcourant davantage de pas, lorsqu’ils utilisaient la RA. En revanche, il n’y a pas eu de différence significative sur l’indicateur des émotions environnementales, potentiellement en raison du rôle inhibiteur de l’écran de la tablette, qui limite un contact direct avec la nature. Les résultats de cette étude ont été publiés dans un article revu par les pairs [5].

Lors du test, les élèves ont exploré la moitié du parcours pédagogique au moyen d’une carte et de postes en papier.

Lors du test, les élèves ont exploré la moitié du parcours pédagogique au moyen de l’application mobile BiodivAR.

Les enseignements de ce projet de recherche sont multiples. Premièrement, nous avons pu surmonter certains obstacles qui limitaient l’utilisabilité de la RA géolocalisée, indispensable à une utilisation grand public. Certains problèmes liés à la précision demeurent, et nous avons ouvert certaines pistes d’amélioration par la fusion de données de suivi positionnel. Deuxièmement, nous avons conçu un outil convivial et complet, qui permet la création de parcours augmentés par des non-spécialistes. L’interface en ligne est à la disposition du public à l’URL <biodivar.heig-vd.ch>. Enfin, en étudiant les mécanismes d’attention et comportements d’utilisation avec la RA, nous avons mieux compris le rôle que ce type d’outil pouvait jouer. En superposant des informations contextuelles à la réalité en temps réel, elle permet de communiquer une information pertinente «en temps et en heure», facilitant sa rétention. Mais étant donné l’attention considérable que cette interface requiert de la part de l’utilisateur, son utilisation ne permet pas une immersion véritable dans le milieu naturel, qui est un objectif essentiel de l’apprentissage de la biodiversité en contexte. Pour ces raisons, nous poursuivrons l’objectif de l’apprentissage de la biodiversité à travers d’autres outils et méthodes. Le projet BioEduNum (2024-2026), par exemple, explore l’impact d’un cadrage pédagogique calqué sur les principes de la science citoyenne. Le mobile sera également utilisé lors d’une exploration de la nature, mais dans une moindre mesure. L’accent sera désormais placé sur l’intérêt que suscite la participation à des projets collectifs de récolte de données, avec des interactions ludiques et des visualisations spatiales au moyen de cartes 3D.

Le projet BiodivAR a été conduit en partenariat avec la Haute école pédagogique de Lausanne (HEP Vaud), avec le soutien du Fonds National Suisse (Projet National de Recherche n°77 «transformation numérique») et du fonds stratégique de la HES-SO.

L’application BiodivAR et la bibliothèque logicielle LBAR.js a été développée par l’institut d’ingénierie des médias de la HEIG-VD.

Organisations:

- HEP Vaud, UER Médias, usages numériques et didactique de l’informatique

- HEIG-VD, Media Engineering Institute

- Université de Genève, équipe IDEA

- Lab-STICC, CNRS, UMR 6285

- Fonds national suisse, Programme national de recherche « Transformation numérique » (PNR 77)

- Swissuniversities

- HES-SO

HEIG-VD/Media Engineering Institute :

Conduite du projet :

- Olivier Ertz

- Julien Mercier

- Daniel Rappo

Développement technique :

- Gregory Dozot

- Nicolas Chabloz

HEP Vaud, UER Médias, usages numériques et didactique de l’informatique :

- Catherine Audrin

Université de Genève, équipe IDEA (Instruction, Développement, Éducation et Apprentissage) :

- Emmanuel Sander

- Laura Leon Perez

Lab-STICC, CNRS, UMR 6285 :

- Erwan Bocher

Remerciements :

- Pro Natura Vaud

- L’établissement primaire et secondaire Isabelle-de-Montolieu, Lausanne

- Fondation SILVIVA

- Engin Bumbacher

- Giovanni Colavizza

- Anne Atlan, CNRS

- Sébastien Guillaume, institut d’ingénierie du territoire (INSIT)

- Jens Ingensand, institut d’ingénierie du territoire (INSIT)

- Maryam Lotfian, institut d’ingénierie du territoire (INSIT)

- Marylène Grzesiak

- Yoann Douillet, MEI

- Ismaël Zosso, HEP Vaud (centre de compétences en outdoor education)

- Corinne Marlot, HEP Vaud (didactique des sciences de la nature)

- Les ~250 participant·e·s aux divers tests utilisateurs

Références :

[1] J. Mercier, N. Chabloz, G. Dozot, O. Ertz, E. Bocher, and D. Rappo, “BiodivAR: A Cartographic Authoring Tool for the Visualization of Geolocated Media in Augmented Reality,” ISPRS International Journal of Geo-Information, vol. 12, no. 2, Art. no. 2, Feb. 2023, doi: 10.3390/ijgi12020061. [2] J. Mercier et al., “IMPACT OF GEOLOCATION DATA ON AUGMENTED REALITY USABILITY: A COMPARATIVE USER TEST,” Int. Arch. Photogramm. Remote Sens. Spatial Inf. Sci., vol. XLVIII-4/W7-2023, pp. 133–140, Jun. 2023, doi: 10.5194/isprs-archives-XLVIII-4-W7-2023-133-2023. [3] J. Mercier, O. Ertz, and E. Bocher, “Quantifying dwell time with location-based augmented reality: Dynamic AOI analysis on mobile eye tracking data with vision transformer,” Journal of Eye Movement Research, vol. 17, no. 3, Art. no. 3, Apr. 2024, doi: 10.16910/jemr.17.3.3. [4] J. Mercier, O. Ertz, and E. Bocher, “‘Look at the trees’: A verbal nudge to reduce screen time when learning biodiversity with augmented reality,” Computers in Human Behavior Reports, p. 100614, Feb. 2025, doi: 10.1016/j.chbr.2025.100614. [5] J. Mercier, L. Leon Perez, C. Audrin, E. Bocher, O. Ertz, and E. Sander, “The impact of augmented reality on biodiversity learning: An experimental study,” Computers in Human Behavior Reports, vol. 20, p. 100801, Dec. 2025, doi: 10.1016/j.chbr.2025.100801.

+ There are no comments

Add yours